EUWでLevelActorの値制御

UnrealEngine で作業効率化!

今回はUE4のEditorUtilityWidgetを使って、

Actorをセットしたら簡単にパラメータ制御ができるテスト!

SinglePropertyViewの設置。

パラメータ変更するボタンも設置。

11月 16, 2022 dekapoppo

UnrealEngine で作業効率化!

今回はUE4のEditorUtilityWidgetを使って、

Actorをセットしたら簡単にパラメータ制御ができるテスト!

SinglePropertyViewの設置。

パラメータ変更するボタンも設置。

10月 27, 2022 dekapoppo

実写の撮影動画にStableDiffusion使ってみた。

■所感

・WEB UI使ってるからか、手順は超簡単!

・結局 img2img のトライアンドエラー膨大(prompt エンジニアリング力あがれば最短ルートで近づける?)

・結局 ルック(テイスト、画風)がフレーム感でずれる(他の人がやっているような定めるのが難しそう)

・ネガティブプロンプトの多用はやっぱり効果的(元素法典の手法)

・ローカルのSDは使い放題で気持ちが楽

■結果

・プロンプトエンジニアを学ぶ

・AI画像生成のことを学ぶ(ベクトル空間?)

動画は真ん中が撮影素材。

上下がimg2img適用。

・AUTOMATIC1111使用

・バッチ書き出し後は、AE+AMEで動画変換

10月 20, 2022 dekapoppo

★★★Dir2Flipbook★★★

今回やったこと

フォルダ内の複数枚の透過PNGを1枚に結合するのを自動化。

WEB上はたくさんの「画像結合ソフト」がある!

ただ、試した見たもののやりたいことと若干ずれてたので

欲しい機能だけに絞ったPython作った。

<機能>

・フォルダ内の画像を1枚に結合

・透明度(アルファ)保持

・解像度に制限なし

・ただし、PNG専用

<使い方>

①Pythonをダウンロードして、3箇所変更する

フォルダパス、横枚数、縦枚数

pip install Pillow

<コード>

10月 08, 2022 dekapoppo

AUTOMATIC1111を更新すると、Checkpoint Mergerが追加されてた。

なんぞこれ?

Checkpointはつまり学習済みモデルのこと、と理解。

StableDiffusionのモデルも model.ckpt として格納してた。

で、その名の通りモデルをマージすることができるらしい!!

(参考 https://twitter.com/atsumi_y/status/1574769089566113795?s=20&t=YHwcmcP1-7mfEgWOW071cg)

試したので、メモ。

①マージするモデルをダウンロード

Waifu-diffusionを追加で用意した

https://huggingface.co/hakurei/waifu-diffusion-v1-3

②所定のフォルダに格納、リネーム

StableDiffusion用にセットアップしたAUTOMATIC1111なので、

Stable-diffusionフォルダ内にモデルを格納。

ckpt名は "-"ハイフンが無いようにリネーム。

③マージ

モデルを2つ指定して、Runするだけ。

超絶簡単。

時間は⑩分ほど?

ファイルサイズは2つの中間くらい(4GBと7GBで、6GBになった)

④text to imageテスト

SD、WD、SDとWDを50:50でマージ した3つのモデルで検証。

同じプロンプトで比較。

10月 02, 2022 dekapoppo

■おすすめ Settings

・ファイル名変更

・サブフォルダに格納

・生成したら通知

参考サイト

https://gigazine.net/news/20220928-automatic1111-stable-diffusion-webui-settings/

■CFG Scaleとは

高いほどPromptに忠実になる。ただ荒れる。

⇔低いと安定するが、Promptを無視する

9月 24, 2022 dekapoppo

「スマホでFacialCaptureができる」時代、ってことで

最新のソフトの実状検証。

仕事で Dynamixyz 使ったものの、やりたいことを実現するための作業コストの高さから挫折した経験も踏まえて、検証してみる。

Faceware Studio

Epicがチュートリアルも作って押しているFacialAnimationのソフト。

フロー的には以下の通り。

顔撮影

↓動画ファイル読み込み or WEBカメラ

Faceware Studio でTrackingと信号送信

↓専用のLiveLinkプラグインでリアルタイム連動

UE で「Faceware専用BP」により信号受信、それをMetahumanに流してリアルタイムフェイシャルアニメ

Dynamixyzはじめ他のソフトと変わらない。

------------------------------------------------

先に、重要リンク3つ

①Epic公式チュートリアル(Faceware+Metahuman)

https://dev.epicgames.com/community/learning/courses/d66/metahuman-workflows-with-faceware-studio/bL8y/unreal-engine-livelink-client

②サンプルUEプロジェクト(Epic)

https://www.dropbox.com/sh/qd0nyv3banf6ch1/AABbSk9sC8R2ZeycMXvk4mQ_a?dl=0?dl=1

③Faceware用のBP ダウンロード(Faceware)

http://support.facewaretech.com/live-link-plugin

--------------------------------------------------

ここからは使ってみた所感。

■FacewareとUEの連動

これは素晴らしい!簡単!

撮影素材→Tracking(デフォ自動、計算一瞬)→UE連動 の流れが超簡単速い。

(今後それぞれのソフトのVersionupにどれだけ対応するか知らんけど)

■Faceware でのチューニング

・・・・これが、

結局フェイシャルのOptimizeが大変です。 Profileつくるのが大変(眉毛の右の下部、とか超細かい設定をしまくらないといけないのが)なので、やっぱりこれはやらないことにする。AI活用期待。。。

取り急ぎ、以上!

9月 20, 2022 dekapoppo

■ GOOD(試したみて良い点)

・SeamlessTexure超簡単 Tiling=on するだけ

・X/Y plot の使い勝手慣れてきた

①繰り返し、いい感じで②繰り返し。Seed活用で狙った画に近づける

・Seam具合はBlenderで確認

・AUTOMATIC1111 毎日更新してるらしい。Git pull。→Seed Bake?が便利そう

■ まだうまく使いこなせていない点

・初期パラメータ変更(ui-config.json)がうまく反映しない

・512x512で生成したあとの高解像度化がうまくいかない

9月 15, 2022 dekapoppo

ローカル環境で StableDiffusion を試してみたところ

txt2img が成功したので、続けて img2img も試してみた。

以下サイトを参考にして、無事成功した !🙏

https://self-development.info/%E3%80%90stable-diffusion%E3%80%91img2img%E3%81%AE%E3%82%A8%E3%83%A9%E3%83%BC%E8%A7%A3%E6%B1%BA%E6%96%B9%E6%B3%95/

また、Pythonでコードをカスタマイズして、

・生成される画像ファイル名の末尾の連番をインクリメントセーブする

・promptなどのパラメータをテキストで保存する

というのも実装できた!

※一応Code貼っておきます(py3.9)

・・・けれど、

地味に時間かかるし、使い勝手悪いので、ちょっと先行き怪しい、、、

とのことで、ちまたで騒がしい既存の超便利なWebUIを試してみる!

色々ありすぎるが、自分の用途が達成できそうな

-----------------------------------

「AUTOMATIC1111版Stable Diffusion web UI」が良さそう。

全部入り機能だが、特に気になった機能4選!!!

・Inpainting:特定の部分の描き直し ・Stable Diffusion upscale:512x512で作成後、高解像度化機能 ・Loopback:作成した画像をinputにして繰り返すことで、ブラッシュアップする ・Textual Inversion:自分で用意した学習データを使う

-----------------------------------

ということで、次回は、、、

■Stable Diffusion web UI(AUTOMATIC1111版)のインストール

https://gigazine.net/news/20220907-automatic1111-stable-diffusion-webui/

■基本の「tex2img」

https://gigazine.net/news/20220909-automatic1111-stable-diffusion-webui-how-to-use/

■クリエイティブを加速せよ「img2img」

https://gigazine.net/news/20220913-automatic1111-stable-diffusion-webui-img2img/

を試す!

ひとまず、ローカルのVRAMが12GBあるので ローカル環境でためそう。

どっかのタイミングで、Google Colabを使ってみたい。

9月 14, 2022 dekapoppo

・StableDiffusionを回数気にせず試したい!

・機械学習についてPythonとともに学びたい!

ということで、トライしたところ

なんとか開発環境構築が終わり、ローカルで何回でもStableDiffusionを使えるようになった!

たので備忘録メモ!

■事前チェック

CUDA 11.6をインストール済み

↓

■Python3.9インストール

C:\Users\{userName}\AppData\Local\Programs\Python\Python39

(デフォルトのまま)

↓

■仮想環境

任意のフォルダに仮想環境を構築(今回はC:\Python39)

>cd C:\Python39

>py -3.9 -m venv my_venv

↓

■パッケージインストール

仮想環境にインストールしたいので、

まず仮想環境への切り替え(仮想環境 .venv ディレクトリのactivate.batを実行)

>C:\Python39\my_venv\Scripts\activate.bat

この状態で、まず pip upgrade。

(.venv) >C:\Python39\my_venv\Scripts\python.exe -m pip install --upgrade pip

続けて、pipでインストール。 ※仮想環境を作ったときのバージョンになる

(.venv) >python -m pip install <package name>

・PyTorch

(.venv) >python -m pip install torch

・Transformers【仮想環境にインストール推奨】

(.venv) >python -m pip install tranformers

・Diffusers【仮想環境にインストール推奨】

(.venv) >python -m pip install diffusers

↓

■Diffusersの動作確認

pythonをコピペして、仮想環境で実行→OK

↓

■StableDiffusionの動作確認

Pythonをコピペして、仮想環境で実行 →OK !簡単

もし、PyTorchエラーがでたら、PyTrochを入れ直してみる。

・PyTorch入れ直し

(my_venv) >pip list

で +cu116 が入っていないものをアンインストール

(my_venv) >pip uninstall torch

つづけてインストールし直し。

(my_venv) >pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu116

※https://pytorch.org/

--------------

StableDiffusionのテストPython

============================================

■参考サイト(諸先輩の説明に感謝)

・ローカル環境でStableDiffusionを実行する

・DreamStudio金額は?

・Prompt参考(lexica)

https://lexica.art/?q=city++siver&prompt=d9b2c577-5083-4b76-9de0-e01117682f56

・Promptまとめ

CUDA / Diffusers / Python / PyTorch / StableDiffusion / Transformers

9月 01, 2022 dekapoppo

備忘録

GitHubで、初めてちゃんとリポジトリをプッシュしてみた。

■やったこと

・GitHubでリポジトリ作成

・TortoiseGitでクライアント側操作

・ローカルのフォルダ&ファイルをリモートリポジトリに反映

■重要 事前設定変更

■【手順】ローカルのフォルダをリモートリポジトリにする

①管理したいローカルのフォルダ名を使って、Gitにリポジトリ作成。

→ここでURLコピーしておく(Code。httpからOK、gitからNG)

②ローカルのフォルダで右クリックして「Git create repository here」

→.gitのフォルダが作成される

※まだここでは反映していない

③ローカルのフォルダで右クリックして「Commit」。

チェック入れて、コメント入れて、「Commit&Push」

ここで、URLを聞かれるので以下の通り回答。

URL入れるダイアログで 「Manage」ボタン押す。

→次のダイアログのURLにURL入れる。(httpからの)

→AddNew/Save

→OK

→OK

→Close

④以上で、GitHub のリポジトリ確認すれば、ローカルのファイルがアップ(Push)されています!

■【手順】リモートリポジトリをローカルフォルダに反映

①ローカルフォルダで右クリック「Git Clone...」

→事前にフォルダは空にしておく

②URLを聞かれるので、リモートリポジトリのURLをコピペ

→Directoryはフォルダを新規作成するか決める

以上。

■個人的ポイント

・Commit&Push をつかう

・プルリクエスト ←全体にプッシュしたこと伝える

8月 30, 2022 dekapoppo

前回の初使用「Midjourneyで日本の神社画像を生成してみるテスト」に続き、

AI画像生成テスト第2段!試したメモ。

・・・・・無料残り回数7回!

「広葉樹林の山にそびえたつ和風木造建築」で生成した画像。

8月 28, 2022 dekapoppo

初めて本格的にMidjourneyを使ってみた。

「美しい雲の切れ間から光が差し込む神社」で生成した画像。

以下備忘録メモ。

このページを参考に始めた。

https://ciclo.jp/midjourney-discord/

PCにDicordをインストール。

グループに参加。

そして、 /imagine つかって指示。

指示の出し方はこちら参考にさせてもらいました、まじ感謝。

https://note.com/shi3zblog/n/n9e3976f0c7f4

/info で残り時間を確認。

アスペクト比をデフォルトの1:1から変更

https://trpg-japan.com/knowledge/how-to-use-midjourney/

高解像度にする

https://mutsumutsu-daifuku.com/howto-midj/

Uボタン→ もしくはコマンドでできた。

■個人的メモ

・高解像度の写真風 冒頭に追加

hyperdimensional photography of

・ジブリ風 末尾に

in Hayao Miyazaki style

■最後に、テスト画像を貼ります

8月 14, 2022 dekapoppo

MPK mini Software managerでインストール。

AdvanceModeで起動すると、Plugin項目が出てくる。

インストール。

MPC beat 起動して、Edit/Preference/Pluginsで

以下フォルダを指定してScanNewする

C:\Program Files\AIR Music Tech

C:\Program Files\Steinberg\vstplugins

すると、

Pluginの選択画面に VST が表示されて選択できるようになる

参考

https://youtu.be/E0iTpDk_DJY?t=175

8月 13, 2022 dekapoppo

やったこと備忘録

カメラをMIDIで制御

VariantManagerでカメラアングルセット作成、切り替えれるように登録

それをMIDIで制御

①UEでMIDIの受信

②PlayせずにEditorでMIDI受信

③アクターをMIDIで制御

④LevelVariantSetの切り替えをMIDIで制御 ★

以上

参考

②について

https://www.youtube.com/watch?v=cdIm-ZthUsk

7月 20, 2022 dekapoppo

Facial / LiveLink / MotionCapture / UE / Unreal

5月 31, 2022 dekapoppo

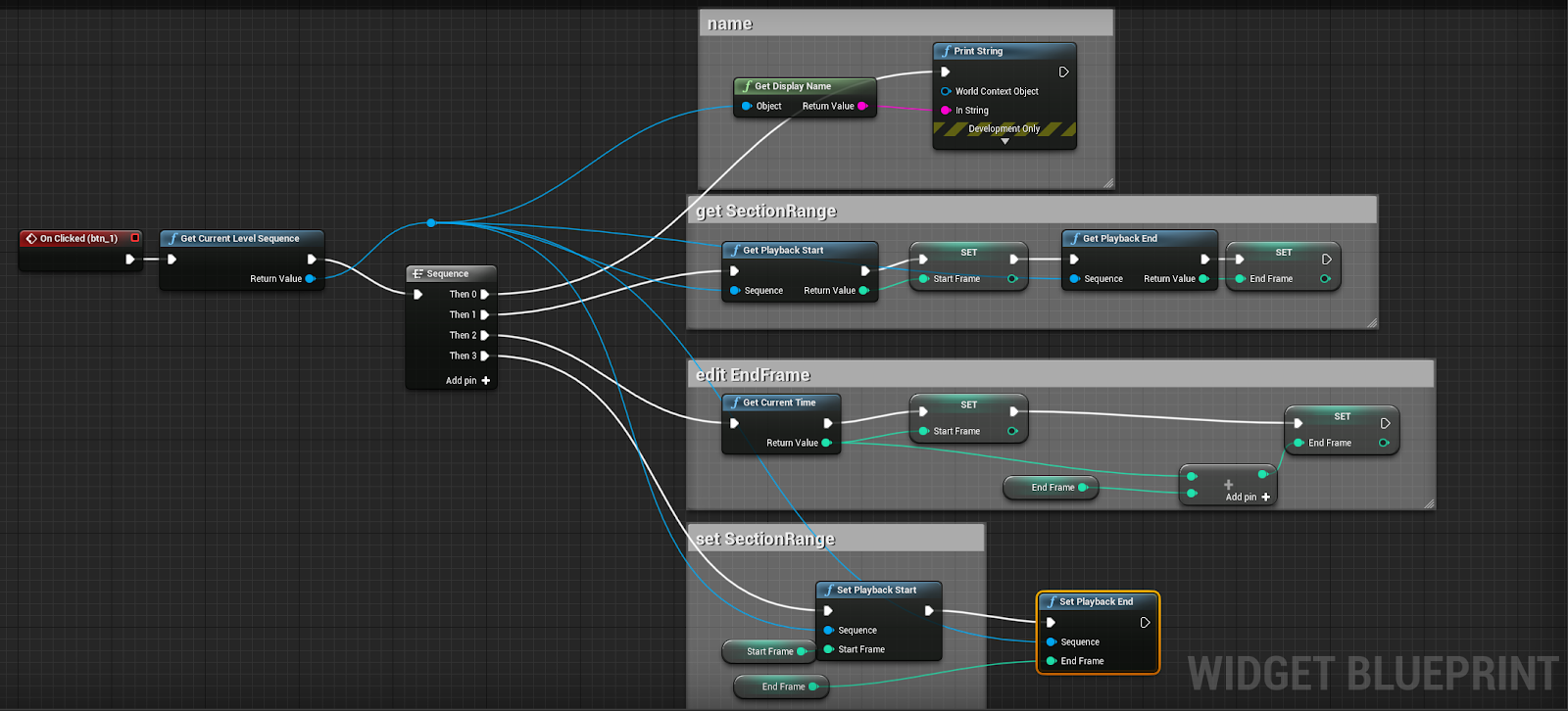

UE4.27のEditorUtilityWidgetで実装。

<やりたいことリスト>

■カレントシーケンサーのIN/OUT変更

・開始位置だけ指定してシフト移動

・カレントシーケンサーのカレントタイムに合わせる ★1

・IN値 指定

・IN/OUT値 それぞれ個別に指定

■選択したシーケンサーのIN/OUT変更

・開始位置だけ指定してシフト移動

・カレントシーケンサーのカレントタイムに合わせる ★2

・IN値 指定

------------------------------------------------------

ひとまず上記の★1,★2だけ作成。

残りは、また時間見つけてやります!

以下スクショ。

GUI

★2

5月 24, 2022 dekapoppo

https://terriblejunkshow.com/tutorial/howtomakescript01

このさいとを参考に、ExtendScript Debuggerをインストール。

↓のアイコン参考!Adobe提供!

(個人が提供してる、名前似たやつに注意)